SARSA与Qlearning算法简介应用举例优缺点分析SARSA算法简介 SARSA算法全称StateActionRewardStateAction,是强化学习中用于策略学习的算法 它通过不断迭代更新Q值函数,考虑了当前状态选择的动作获得的奖励新状态以及在新状态中可能采取的动作应用举例 在4x4冰湖迷宫中,SARSA算法帮助智能体学习。

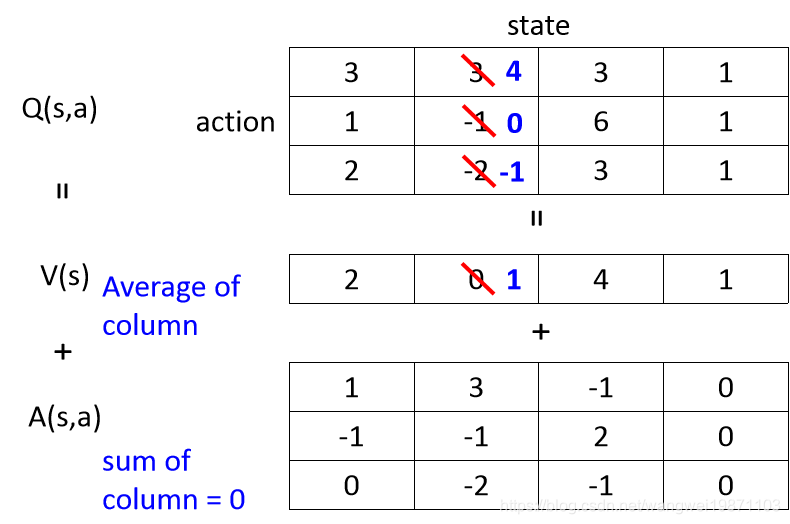

首先,Qlearning算法是一种离线学习策略,其核心在于通过与环境互动来学习最优策略在Qlearning中,每一步都会基于当前状态和采取的动作来更新Q值表,即所谓的状态动作值函数,以便在未来做出更优选择公式为Qs,a = Qs,a + α r + γ max Qs#39, a#39 Qs,a其中,Q。

Qlearning是强化学习中一种基于价值的离轨策略的无模型的在线算法,它通过一个Q表来近似状态动作对的价值Q表存储着在给定状态和动作下期望获得的累计奖励对于经典的悬崖寻路问题,智能体通过与环境交互学习到最优策略,最终成功找到最短路径到达终点在确定性环境中,Qlearning算法能够收敛到最。

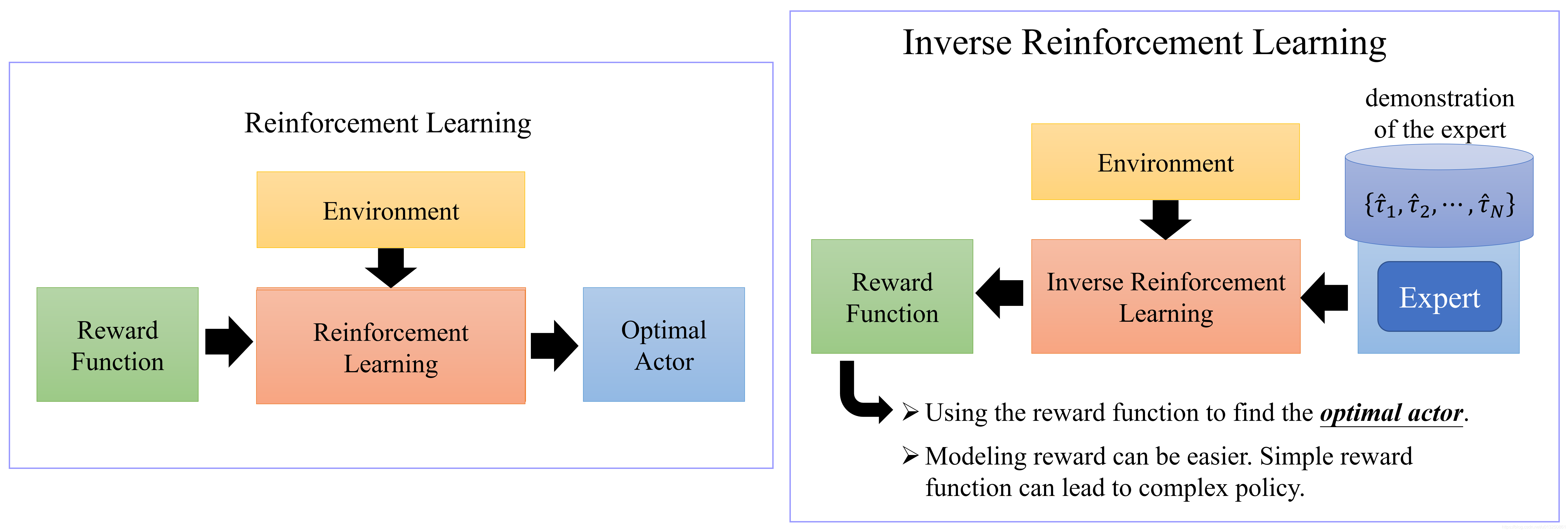

Qlearning算法的关键在于奖励函数的设定,这是强化学习成功的关键因素通过设定合理的奖励函数,智能体能够学习到最优策略在实际应用中,Qlearning算法存在一些限制,特别是在连续状态和动作空间中为了解决这个问题,引入了QNetworksDQN等算法,它们使用神经网络拟合值函数DQN算法通过引入经验回放。

SARSA算法,全称StateActionRewardStateAction,是强化学习中用于策略学习的算法,由Rummery和Niranjan在论文quotModified Connectionist QLearningMCQLquot中提出,由Sutton在注解中引入了SARSA这一别名算法核心基于当前状态S选择的动作A获得的奖励R新状态S2以及在S2中可能采取的A2其学习过程是通过。

随着学习的进行,逐渐偏向利用已知策略,以提升性能关键步骤QLearning算法的关键步骤包括初始化Q表应用Epsilongreedy策略选择动作执行动作并观察结果利用时间差分方法更新Q值优势QLearning通过灵活的策略调整和智能的学习策略更新,帮助代理在复杂的强化学习环境中找到最优决策路径。

发表评论